Note aux lecteurs qui passent par là : la primaire de la droite et du centre aura eu le mérite de me faire réécrire en français ! Il s’agit cependant essentiellement d’un prétexte pour parler de mon occupation actuelle… la théorie de la décision !

Dans sa version positive, la théorie de la décision (TD) est un corpus théorique visant à expliquer et à prédire les choix d’agents satisfaisant certaines conditions de rationalité dans des contextes caractérisés, notamment, par divers degrés d’incertitude. Dans sa version normative, la TD énonce un certain nombre de conditions que doivent satisfaire les choix et les raisonnements d’agents rationnels. Pour l’essentiel, la TD est « bayésienne » : les jugements et les choix des agents rationnels doivent répondre aux lois des probabilités, en particulier concernant la manière dont les jugements des agents concernant les probabilités d’occurrence d’un évènement donné (leurs croyances) doivent prendre en compte une information nouvelle. Dans ce cadre, les préférences d’un agent sur un ensemble d’alternatives faisant l’objet d’un choix dépendront de deux éléments : leur évaluation de la désirabilité des conséquences que peuvent les alternatives et leur évaluation de la probabilité de ces conséquences étant donnée l’alternative choisit.

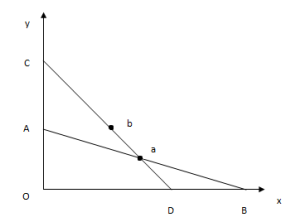

Formalisons quelque peu les choses. Soit W un ensemble de propositions « basiques » X sur lesquelles les jugements (croyances et désires) de l’agent rationnel portent. A ∈ W est un sous-ensemble de (disjonctions de) propositions décrivant les choix de l’agent. Formellement, ce sont des propositions dont la véracité est entièrement contrôlée par l’agent lui-même. Dans sa version la plus générale, la TD énonce que la valeur associée à n’importe quelle proposition X, notée V(X), est déterminée par l’expression suivante :

- V(X) = ∑ip(Si & A|X).u(Si & A), avec A ∈ A et ∀i : Si ∈ W.

L’expression (1) indique la valeur de n’importe quelle proposition X est donnée par la désirabilité de la conjonction de l’action A et d’un état de nature Si, mesurée par une fonction u, pondérée par la probabilité conditionnelle d’occurrence de la conjonction Si & A étant donnée X, mesurée par une fonction p. Si X = A (i.e. l’agent sait avec certitude que A est vrai) alors (1) devient

- V(A) = ∑ip(Si|A).u(Si & A), avec A ∈ A et ∀i : Si ∈ W.

Un agent rationnel choisira n’importe quelle alternative A pour laquelle il n’existe pas d’alternative A’ telle que V(A’) > V(A). Supposons qu’une information X soit portée à la connaissance de l’agent. Par exemple, un potentiel candidat à la présidence de la République, que nous appellerons François B., devant décider s’il se présente ou non, et dans ce dernier cas quel autre candidat soutenir, apprend qu’un certain François F. a remporté la primaire du droite et du centre avec une large avance sur Alain J. Comment François B. doit-il prendre en compte cette information pour réévaluer la valeur des différentes alternatives à sa disposition (se présenter ? quel candidat soutenir ?), compte tenu de ses croyances et objectifs initiaux ? Autrement dit, comment doit-on définir l’expression V(A|X) ?

Dans un cadre bayésien classique, l’information X va être pris en compte par l’agent rationnel au travers de la règle de Bayes. Si on note p(SiA) = p(Si|A), dans ce cas la croyance actualisée p*(SiA) de notre agent une fois l’information X reçue sera

- p*(SiA) = p(SiA|X) = p(SiA & X)/p(X).

L’information X doit par ailleurs, d’un point de vue bayésien, être intégrée dans l’évaluation de la désirabilité de l’action A. La nouvelle évaluation devient alors

(Bayes) V*(A) = ∑ip*(SiA).u(Si & A & X) = ∑ip(SiA|X).u(Si & A & X).

Concrètement, l’information X que François F. a gagné la primaire doit permettre à François B. de réviser sa croyance, par exemple, de l’emporter dans le cas où il se présente. La révision de ses croyances va alors à son tour entrainer une révision de ses préférences concernant les différents objets contenues dans l’ensemble A.

L’approche bayésienne stricte souffre toutefois d’un certain nombre de difficultés. Dans le cas d’espèce, le principal problème vient du fait que l’on suppose que l’information X est connue de François B. de telle sorte qu’il lui assigne une probabilité de 1, ce qui lui permet d’appliquer la règle de Bayes. Or, la victoire de François F. peut signifier différentes choses, par exemple quant à la nature des attentes de l’électorat de droite, quant au positionnement des futurs candidats de gauche, etc. Autrement dit, plutôt qu’une seule et unique information X, la victoire de François F. véhicule une partition d’informations X = {Xj}. L’idée est d’admettre la possibilité que le même évènement (la victoire de François F.) puisse être interprété de différentes manières. Formellement, cela se traduit par un changement dans les probabilités que François B. assigne à chaque élément de la partition X. Ces nouvelles probabilités viennent alors pondérer l’actualisation bayésienne, ce qui donne

- p*(SiA) = ∑jp(SiA|Xj).p*(Xj), avec p*(Xj) la nouvelle croyance de François B. dans la proposition Xj.

Cette forme d’actualisation a été proposée par le philosophe Richard Jeffrey comme alternative à l’actualisation bayésienne. Elle repose sur le fait que les croyances « fondamentales » des agents ne sont pas fixes mais peuvent évoluer de manière indéterminée. Bien entendu, cette révision va à son tour entrainer une révision des préférences de l’agent :

(Jeffrey) V*(A) = ∑i∑jp(SiA|Xj).p*(Xj).u(Si & A & Xj).

Outre le fait qu’elle permet de tenir compte du fait qu’une information peut véhiculer un message ambigu, l’actualisation de Jeffrey permet également de rendre compte de manière plus satisfaisante des évènements imprévus et autre « surprises ». Si l’on considère que la victoire de François F. était largement non envisagée il y a encore un mois et demi, François B. assignait alors probablement une probabilité 0 à la proposition X. Le problème dans ce cas, bien entendu, est la règle de Bayes est inapplicable. L’actualisation de Jeffrey ne souffre pas de cette difficulté. Par ailleurs, même si l’on considère que François B. n’assignait pas une probabilité de 0 à X (ce que tout bon bayésien ne devrait jamais faire), l’approche bayésienne standard est très peu économe en termes de ressources computationnelles conférées à l’agent puisqu’elle suppose que ce dernier a une partition assez fine des états du monde (ou dispose d’une liste suffisamment large de propositions, ce qui revient au même) pour envisager un évènement tel que la victoire de François F.

Il reste cependant un dernier point non pris en compte par l’approche de Jeffrey : la victoire de François F. peut amener à réviser non seulement ses croyances mais aussi ses désirs fondamentaux. Par exemple, si l’on considère que cette victoire de François F. indique que les idées plus centristes ne seront pas représentées à l’élection, cela peut amener François B. à conférer plus de valeur à tous les états du monde où il se présente. Dans ce cas, outre l’actualisation à la Jeffrey, François B. doit aussi actualiser ses désirs de la manière suivante :

- u*(Y) = ∑j[u(Y|Xj) + u*(Xj)].p*(Xj|Y) = ∑j[u(Y & Xj) – u(Xj) + u*(Xj)].p*(Xj|Y) pour toute proposition Y ∈ W

Ce principe d’actualisation général englobant les croyances et les désirs est notamment proposé par Richard Bradley. L’évaluation révisée des alternatives est alors déterminée par l’expression suivante :

(Bradley) V*(A) = ∑i∑jp(SiA|Xj).p*(Xj).u*(Si & A & Xj)

= ∑i∑jp(SiA|Xj).p*(Xj).[u(Si & A|Xj) + u*(Xj)].p*(Xj|Si & A).

Bien entendu, la TD qu’elle soit bayésienne ou non, ne peut pas dire à François B. ce qu’il doit faire dans l’absolu, mais seulement en fonction de ses croyances et désirs. A contrario, les choix futurs de François B. combinés à ce cadre théorique nous permettrons d’inférer (dans une certaine mesure) ses croyances et ses désirs, ainsi que la manière dont il les a actualisés !